AIの導入が本格化する中で、GPUリソースや高速ストレージを効率よく活用できるサーバ基盤の重要性が高まっています。

その中でも、LenovoのAI対応サーバラインナップは、エッジからデータセンター、さらにはHPC環境までを幅広くカバーする点で注目を集めています。

本記事では、LenovoのAI対応サーバ群のうち、特に「筐体ごとの構成・用途の違い」に焦点を当てて解説します。

LenovoのAIサーバは大きく以下の3カテゴリに分けられます。

- 小型・耐環境型の「ThinkEdge」シリーズ(エッジAI向け)

- データセンターでのAIワークロードに適した「ThinkSystem」ラック型サーバ

- スーパーコンピューティングや大規模AI学習向けの高密度GPU搭載モデル

それぞれに独自の強みがあり、ユースケースや設置場所、GPU要件に応じて最適な筐体を選ぶことが重要です。

エッジAIに特化:ThinkEdgeシリーズの特徴と用途

AIの活用はクラウドやデータセンター内にとどまらず、製造現場や店舗、交通インフラといった「エッジ環境」にも広がりを見せています。

Lenovoの「ThinkEdgeシリーズ」は、まさにこうした厳しい温度条件・限られた設置スペース・物理セキュリティ要件に対応するために設計されたAIサーバ群です。

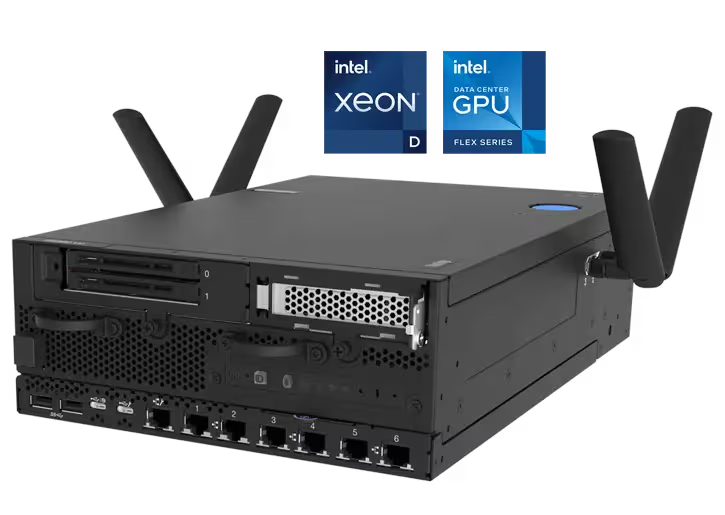

ThinkEdge SE350 V2 / SE360 V2

これらのモデルは、コンパクトな筐体(最大2U)と高い耐環境性を兼ね備えたエッジ向けAIサーバです。

- 設置自由度の高い筐体設計:ラックマウント、壁面、棚、さらには車両内への搭載にも対応

- 過酷環境に耐える設計:広範な動作温度、耐衝撃・耐振動仕様

- セキュリティ機能の充実:物理的改ざん検知、TPMによる暗号化キー管理、ThinkShieldによる遠隔キー保管

通信インターフェースも豊富で、1G/10G/25Gの有線LANに加え、2.5G TSN対応やBluetooth/WLANもサポート。

IoTデバイスからのデータ収集・分析をリアルタイムで実施したい現場に最適です。

ThinkEdge SE450 / SE455 V3

やや大型のSE450/SE455 V3は、より高度な推論処理やAI前処理にも耐えるミッドレンジモデルです。

- 最大2基のAMD EPYC搭載(SE455 V3)

- GPU×2基(最大300W級)に対応し、ローカル推論や画像解析処理が可能

- SE450は高静音設計で、オフィスや屋内環境にも適合

工場の生産ライン映像のリアルタイム分析や、現地での前処理を行いクラウド送信するような分散AI環境において、重要な役割を果たします。

データセンター向け汎用AI筐体:ThinkSystemラック型

企業のAI導入において最も汎用的かつ柔軟性が高いのが、LenovoのThinkSystemラックマウント型AIサーバです。

1U〜2Uサイズの標準ラック筐体ながら、GPU搭載・ストレージ拡張・I/O拡張の自由度が高く、AI推論から中規模学習、VDI、HPC用途まで幅広く対応します。

ThinkSystem SR630 V3 / SR650 V3(インテル Xeonモデル)

- SR630 V3は1U筐体、SR650 V3は2U筐体で、どちらも第5世代Intel Xeon Scalable Processorを最大2基搭載可能。

- 最大8基のシングル幅GPU、または3基のダブル幅GPUが搭載可能で、AIワークロードに最適化。

- 最大32DIMMのTruDDR5メモリスロットにより、ハイメモリ環境の機械学習・推論にも対応。

- **ストレージ構成は最大40ベイ(SAS/SATA/NVMe)**に拡張可能。NVMeによる高速アクセスを活かしたAI前処理にも有効。

ThinkSystem SR650 V3はGPUワークロードとストレージIOをバランス良く要求される環境(例:製造業のAI解析基盤、画像処理)に特に適しています。

ThinkSystem SR645 V3 / SR655 V3(1CPU) / SR665 V3(2CPU)(AMD EPYCモデル)

AMD EPYC搭載モデルは、PCIeレーンの豊富さ・メモリ帯域の広さが特徴で、より高密度なGPU構成やAI学習用途に向いています。

| モデル | フォームファクタ | CPU | GPUサポート | 特長 |

|---|---|---|---|---|

| SR645 V3 | 1U | 最大2基 EPYC | 最大4基 SW GPU | 高密度1U筐体にGPU搭載可能なバランスモデル |

| SR655 V3 | 2U | 1基 EPYC | 最大8 SW or 3 DW | 高GPU密度+最大40ベイのストレージ拡張 |

| SR665 V3 | 2U | 最大2基 EPYC | 最大8 SW or 3 DW | デュアルCPU+高GPU+大容量ストレージの最上位モデル |

EPYCモデルは、NVIDIA H100などの350W GPUも搭載可能で、生成AIやビッグデータ学習用途に対応します。

特にSR665 V3は、PCIe 5.0×10スロットと大容量ストレージ構成により、オンプレミスのAI学習基盤として有力な選択肢です。

ハイパフォーマンスGPU特化筐体:SR675 V3 / SR685a V3など

近年の生成AIやディープラーニングモデルは、数百億以上のパラメータを持つ大規模構造が主流となっており、それらを支えるにはGPU性能の極限まで引き出すサーバ設計が求められます。

Lenovoはこの要求に対して、SXM GPUや液冷対応を前提とした高密度GPUサーバ群を展開しています。

ThinkSystem SR675 V3:汎用GPU対応の3Uハイパフォーマンス筐体

- 最大8基のGPU(SXM / ダブル幅 / シングル幅)に対応

- 第4・第5世代 AMD EPYCプロセッサ(最大2基)を搭載可能

- NVIDIA HGXモジュール構成やPCIe Gen5×16アダプター×6スロットで、I/O帯域のボトルネックを回避

- ドライブベイも最大8台と十分な構成で、ローカルデータ処理やキャッシュ用途に対応

このモデルは、AI学習ワークロードを中心に、GPUあたりの冷却設計・電力供給をバランスよく確保しており、オンプレミスの生成AI学習基盤やVDIにも適しています。

ThinkSystem SR685a V3 / SR680a V3:8U超大型GPUサーバ

GPU最大性能を引き出す構成として、SR685a V3・SR680a V3はGPU 8基構成の最高峰モデルです。

- SR685a V3:AMD EPYCベース、最大8基のAMD Instinct MI300X または NVIDIA H100/H200 GPUを搭載可能

- SR680a V3:Intel Xeonベース、NVIDIA SXM H100/H200 GPU 最大8基をサポート

- PCIe Gen5 x16スロット×10、NVMeベイ×16台といった高帯域I/O+高速ストレージ設計

- 高密度環境下でのGPU間通信にNVLink(SXM)を活用

これらのモデルは、複数ノードに分けるのではなく、1筐体内で最高性能を追求したい企業に向いています。

生成AI、CFD解析、マルチGPU連携による大規模画像処理、モデルチューニングなどの集中処理環境に最適です。

ミッションクリティカル用途:SR850 V3 / SR860 V3

AIインフラといっても、すべてがGPU主体の処理とは限りません。

大規模なメモリ容量、豊富なI/O、安定性を求められる基幹業務系AI(例:ERP連携、金融分析、EHR解析など)においては、信頼性重視の4ソケット対応サーバが重要です。

LenovoのSR850 V3 / SR860 V3は、こうした「ミッションクリティカル領域×AI」を支える堅牢なハイエンドモデルです。

ThinkSystem SR850 V3:バランス型4ソケット対応サーバ

- フォームファクター:2Uラック

- 最大4基の第4世代 Intel Xeon Scalable プロセッサー(250W)を搭載

- 最大64スロットのDDR5メモリで、大容量インメモリ処理や分析ワークロードに対応

- GPU:最大2基のダブル幅 または 3基のシングル幅

- PCIeスロット:最大12+OCP 3.0×2でI/Oの拡張性も確保

多くのコア数と広帯域のメモリバスにより、AIだけでなくSAP HANA、Oracle Database、大規模ファイル処理などの負荷の高い処理にも耐えられます。

ThinkSystem SR860 V3:拡張性に優れた4Uフラッグシップ筐体

- フォームファクター:4Uラック

- 最大4CPU+最大8基のGPU(SXM未対応)

- 最大48台の2.5インチドライブベイにより、ビッグデータ環境にも対応

- PCIeスロット:最大18+OCP3.0×2、あらゆる拡張ニーズに応える

このモデルは、AIワークロードと従来型のエンタープライズアプリケーションを1台で統合するシナリオにも対応できます。

例えば、データベース+AI推論機能+セキュリティ監視を1筐体に集約するといった構成も可能です。

これらのモデルは、単なるAI処理だけでなく、企業の“最も止めてはならない”システムをAI活用と共に支えるサーバとして導入されるケースが多く、冗長電源、RAS機能、モジュール設計など、エンタープライズレベルの要件を満たしています。

HPC/液冷対応筐体:SDシリーズ(SD650/SD665など)

AIやHPCの世界では、消費電力・発熱・ラック密度のすべてが限界に近づいています。

特に、複数基のH100やMI300XなどのハイエンドGPUを搭載する場合、空冷ではもはや限界に達しつつあります。

Lenovoは早くから液冷ソリューション「Neptune™」を展開し、これに対応した高密度・高冷却性能サーバとしてSDシリーズを投入しています。

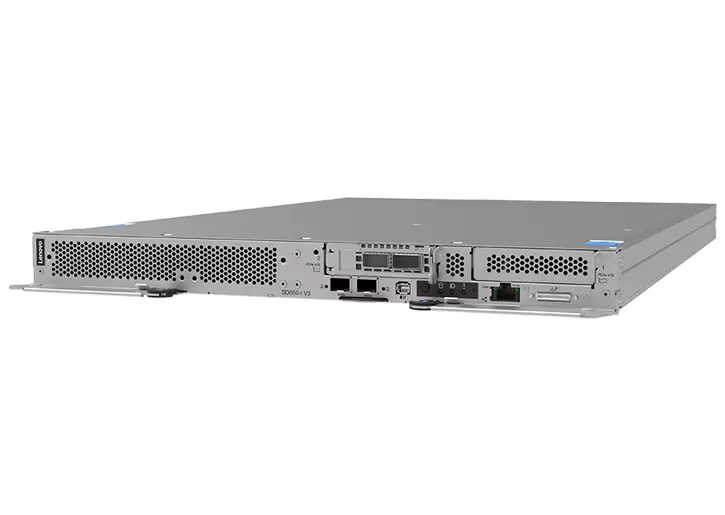

ThinkSystem SD665-N V3:NVLink対応GPU搭載ノード

- 1Uフルワイドトレイ型(1ノード)

- 第5世代 AMD EPYC ×1〜2基搭載可能

- NVIDIA HGX™ H100 ×4基(NVLink)による高速GPU間通信を実現

- 液冷対応設計により、極限まで発熱を抑制

- 最大12スロットのTruDDR5 RDIMM、NVMe×2搭載可

この構成は、AI学習(特にTransformer系)やCFD、分子動力学、レンダリング処理において最大限のGPU性能を引き出す設計となっており、データセンターでのGPUリソース集約と省エネ運用に適しています。

ThinkSystem SD650-I V3:Intel Xeon+Intel GPU Maxの液冷設計

- 第5世代 Xeon または Xeon Maxシリーズに対応

- 最大4基のIntel Data Center GPU Max 1100を搭載

- PCIe Gen5対応 ×16 LPスロット×2、液冷バックプレーン搭載

- 最大16本のTruDDR5 RDIMMスロット

Xeon CPUとの親和性が高く、HPCコード最適化が進んでいる科学技術系AI(例:物性シミュレーションや気象計算)に最適です。

SDシリーズは、単体運用よりも複数ノードでのスケールアウト+液冷によるラック密度向上が最大の特徴です。

また、Neptune液冷インフラとセットで構成提案できるため、サーバ+冷却+ラック設計の統合提案にも対応できます。

まとめ|用途と要件で選ぶLenovo AIサーバ

LenovoのAIサーバラインナップは、設置環境・処理規模・拡張性・冷却方式といった多様な要件に柔軟に対応できる設計となっており、次のように分類できます。

| 用途・シーン | 推奨シリーズ | 主なモデル | 特徴 |

|---|---|---|---|

| 工場・店舗などの現場AI(推論) | ThinkEdgeシリーズ | SE350 V2 / SE360 V2 / SE450 | 小型・耐環境・セキュア・遠隔管理 |

| 一般的なAI推論/VDI用途 | ThinkSystem 1U/2U | SR630 V3 / SR650 V3 | Xeonベース、GPU最大8基、柔軟なI/O |

| 中~大規模学習やVDI集約 | ThinkSystem EPYCモデル | SR645 V3 / SR665 V3など | PCIe 5.0、高GPU密度、NVMe豊富 |

| 高性能GPU学習/生成AI | ハイパフォーマンスGPUサーバ | SR675 V3 / SR685a V3 | SXM対応、NVLink、高密度GPU |

| 信頼性重視の業務AI基盤 | ミッションクリティカル | SR850 V3 / SR860 V3 | 4ソケット対応、超拡張性 |

| 液冷・高密度HPC用途 | SDシリーズ | SD665-N V3 / SD650-I V3 | Neptune液冷、HGX搭載、科学技術計算対応 |

Lenovoは、AIワークロードの全ライフサイクル(エッジ→データセンター→HPC)を単一ベンダーでカバーできる強みがあります。

これは、サーバ単体だけでなく、冷却、電源、ソフトウェア連携、サポートまでを一体化できるエンタープライズベンダーならではのアプローチです。

AIインフラ選定においては、単なるGPU数や価格だけでなく、以下の点もぜひ検討してください

- 設置場所の制約(騒音・温度・振動など)

- 冷却方式と電力消費

- 運用管理性(XClarityなど)

- 物理&データセキュリティ対策

- 今後の拡張性とスケーラビリティ

AI活用は今後ますます高度化・多様化していく中で、最適なハードウェアプラットフォームを選ぶことが成功の鍵となります。

LenovoのAIサーバは、その柔軟性と信頼性において、国内外の多くの企業で導入実績があります。

現場の課題やユースケースに応じて、ぜひ最適な構成をご検討ください。